TL;DR

Ab dem 2. August 2026 wird der EU AI Act vollständig wirksam und ändert damit die strukturellen Anforderungen an KI-Systeme in Europa grundlegend. Compliance wird nicht mehr nur als rechtliche Pflicht verstanden, sondern als architektonisches Merkmal, das in die Produktentwicklung eingebettet sein muss. Europäische KI-Systeme unterscheiden sich dadurch in Design, Dokumentation und Betrieb systematisch von Systemen, die nach anderen Logiken entwickelt wurden.

Der regulatorische Rahmen verändert die Produktarchitektur

Am 2. August 2026 tritt der EU AI Act für Hochrisiko-Systeme in Kraft. Zu diesem Zeitpunkt müssen Anbieter von KI-Systemen in Bereichen wie Biometrie, kritische Infrastruktur, Bildung, Beschäftigung, Finanzdienstleistungen und öffentliche Verwaltung nachweisen, dass ihre Produkte den regulatorischen Anforderungen entsprechen. Die Verordnung (EU) 2024/1689 verlangt von Anbietern nicht nur die Einhaltung von Regeln, sondern eine nachweisbare Integration dieser Regeln in die technische Struktur der Systeme selbst.

Die DSGVO, die seit 2018 in Kraft ist, hatte bereits ähnliche Anforderungen an Datenschutz durch Technikgestaltung etabliert. Der AI Act erweitert diesen Ansatz systematisch. Anbieter müssen technische Dokumentation erstellen, die den Entwicklungs-, Trainings- und Evaluierungsprozess nachvollziehbar macht. Sie müssen Systeme so gestalten, dass automatisch Ereignisse protokolliert werden, die zur Identifikation von Risiken relevant sind. Sie müssen nachweisen, dass ihre Systeme Genauigkeit, Robustheit und Cybersicherheit auf einem angemessenen Niveau erreichen.

Diese Anforderungen sind nicht nachträglich erfüllbar. Sie müssen in die Architektur der Systeme eingebaut werden.

Was sich konkret in der Entwicklung ändert

Die technischen Anforderungen des EU AI Act verändern die Produktentwicklung auf mehreren Ebenen. Zunächst müssen Anbieter ein Qualitätsmanagementsystem etablieren, das Compliance sicherstellt. Das bedeutet strukturierte Prozesse zur Risikoerkennung, Dokumentation und kontinuierlichen Überwachung. Entwicklerteams müssen von Beginn an dokumentieren, welche Daten verwendet wurden, wie Modelle trainiert wurden und welche Evaluierungsergebnisse erzielt wurden.

Für Anbieter von allgemeinen KI-Modellen gelten seit dem 2. August 2025 spezifische Transparenzpflichten. Sie müssen technische Dokumentation bereitstellen, die nachgelagerten Anbietern ermöglicht, die Fähigkeiten und Grenzen des Modells zu verstehen. Sie müssen eine Richtlinie zur Einhaltung der Urheberrechtsrichtlinie entwickeln. Sie müssen eine ausreichend detaillierte Zusammenfassung über die für das Training verwendeten Inhalte veröffentlichen.

Hochrisiko-Systeme erfordern zusätzlich die Gestaltung für menschliche Aufsicht. Das System muss so konzipiert sein, dass Nutzer eingreifen können. Es muss Logging-Funktionen enthalten, die eine Nachvollziehbarkeit über den gesamten Lebenszyklus hinweg ermöglichen. Es muss mit einer CE-Kennzeichnung versehen werden, die belegt, dass es den EU-Standards entspricht.

Diese Anforderungen erzeugen Komplexität. Sie verlangsamen Entwicklungszyklen. Sie erhöhen Kosten. Aber sie schaffen auch Nachvollziehbarkeit, die in kritischen Anwendungsbereichen notwendig ist.

Die Schnittstelle zwischen AI Act und DSGVO

Die DSGVO und der AI Act überschneiden sich in mehreren Bereichen. Beide verlangen Transparenz gegenüber betroffenen Personen. Beide verlangen Datenschutz-Folgenabschätzungen für Hochrisiko-Verarbeitung. Beide verlangen, dass automatisierte Entscheidungen mit erheblichen Auswirkungen menschliche Kontrolle einbeziehen.

Die französische Datenschutzbehörde CNIL hat Empfehlungen zur DSGVO-konformen Entwicklung von KI-Systemen veröffentlicht. Sie betont die Notwendigkeit der Dokumentation verwendeter Datensätze, die aufgrund ihrer Größe schwer nachvollziehbar sein können. Unternehmen müssen diese Dokumentation aktuell halten, wenn sich Datensätze ändern. Sie müssen Aufbewahrungsfristen für Daten definieren, die sowohl für die Entwicklungsphase als auch für den Betrieb gelten.

Besonders relevant wird die Kombination beider Verordnungen in regulierten Sektoren. Im Finanzwesen müssen KI-Systeme ab dem 2. August 2026 nicht nur den AI Act, sondern auch sektorale Regelungen wie DORA einhalten. Der im November 2025 vorgeschlagene Digital Omnibus versucht, diese regulatorischen Überschneidungen zu vereinfachen, indem er eine einheitliche Meldestelle für Vorfälle einrichtet und Meldeschwellen harmonisiert.

Dokumentation als strukturelle Anforderung

Einer der auffälligsten Unterschiede zwischen europäischen und nicht-europäischen KI-Systemen liegt in der Dokumentation. Der AI Act verlangt von Anbietern Hochrisiko-Systemen, technische Dokumentation zu erstellen, die es Behörden ermöglicht, die Konformität zu bewerten. Diese Dokumentation muss kontinuierlich aktualisiert werden. Sie muss Informationen über Datenherkunft, Trainingsmethoden, Evaluierungsergebnisse und Risikomanagement enthalten.

Für allgemeine KI-Modelle gelten ähnliche Anforderungen. Anbieter müssen Informationen bereitstellen, die nachgelagerten Nutzern ermöglichen, die Fähigkeiten und Grenzen des Modells zu verstehen. Diese Informationen sind nicht optional. Sie sind Voraussetzung dafür, dass ein System überhaupt in der EU eingesetzt werden darf.

Die spanische Aufsichtsbehörde AESIA hat im Jahr 2025 16 Leitfäden veröffentlicht, die Organisationen bei der Einhaltung des AI Act unterstützen. Diese Leitfäden decken alle zentralen Verpflichtungen für Hochrisiko-Systeme ab, darunter Konformitätsbewertungsverfahren, Qualitätsmanagementsysteme, Risikomanagement, menschliche Aufsicht, Datengovernance und Transparenz.

Diese Dokumentationsanforderungen erzeugen Mehraufwand. Aber sie erzeugen auch Klarheit darüber, wie ein System funktioniert, welche Daten es verwendet und wo seine Grenzen liegen.

Transparenz und Kennzeichnung von KI-generierten Inhalten

Im Dezember 2025 veröffentlichte die Europäische Kommission den ersten Entwurf eines Verhaltenskodex zur Kennzeichnung KI-generierter Inhalte. Dieser freiwillige Kodex etabliert technische Standards für Wasserzeichen und die Erkennung synthetischer Medien, bevor die Transparenzpflichten am 2. August 2026 rechtlich bindend werden.

Der Kodex verlangt, dass Anbieter generativer KI-Systeme sicherstellen, dass KI-generierte oder manipulierte Inhalte in einem maschinenlesbaren Format gekennzeichnet werden. Das ermöglicht die automatische Erkennung künstlich erzeugter Inhalte. Anwender, die KI beruflich nutzen, um Deepfakes oder KI-generierte Texte zu Themen von öffentlichem Interesse zu erstellen, müssen diese kennzeichnen.

Diese Anforderungen zielen darauf ab, die Verbreitung von Deepfakes und KI-gestützter Desinformation zu bekämpfen. Sie schaffen aber auch operative Klarheit darüber, was von Anbietern und Nutzern erwartet wird.

Warum europäische KI-Systeme anders wirken

Europäische KI-Systeme wirken oft langsamer, komplexer und kontrollierter als Systeme, die nach anderen Entwicklungslogiken entstehen. Das liegt nicht an technischer Unfähigkeit, sondern an strukturellen Entscheidungen.

Ein System, das automatisch Ereignisse protokollieren muss, benötigt zusätzliche Rechenleistung. Ein System, das für menschliche Aufsicht ausgelegt ist, kann nicht vollständig autonom operieren. Ein System, das umfassend dokumentiert werden muss, kann nicht nach dem Prinzip „schnell iterieren und später aufräumen“ entwickelt werden.

Diese Unterschiede spiegeln unterschiedliche strategische Prioritäten wider. Die US-amerikanische Entwicklungslogik folgt oft dem Prinzip der Skalierung. Systeme werden auf Geschwindigkeit und Reichweite optimiert. Regulierung wird, wenn überhaupt, nachträglich adressiert. Die europäische Logik folgt dem Prinzip der Kontrolle. Systeme werden auf Nachvollziehbarkeit und Risikomanagement optimiert. Regulierung ist von Anfang an Teil der Produktarchitektur.

Keine dieser Logiken ist objektiv überlegen. Sie dienen unterschiedlichen Zielen in unterschiedlichen Kontexten.

Compliance als Wettbewerbsvorteil

Ab 2026 wird Compliance in Europa zu einem Produktmerkmal, das Marktzugang ermöglicht. Systeme, die die Anforderungen des AI Act nicht erfüllen, dürfen in bestimmten Anwendungsbereichen nicht eingesetzt werden. Systeme, die die Anforderungen erfüllen, können sich durch nachweisbare Konformität differenzieren.

Die Strafen für Nichteinhaltung sind erheblich. Verstöße gegen verbotene Praktiken können mit Bußgeldern von bis zu 35 Millionen Euro oder 7 Prozent des weltweiten Jahresumsatzes geahndet werden. Verstöße gegen andere Verpflichtungen können Bußgelder von bis zu 15 Millionen Euro oder 3 Prozent des Umsatzes nach sich ziehen. Falsche oder irreführende Informationen können mit bis zu 7,5 Millionen Euro oder 1 Prozent des Umsatzes bestraft werden.

Diese Strafen sind nicht nur finanzielle Risiken. Sie sind auch Reputationsrisiken. Ein Unternehmen, das öffentlich wegen Nichteinhaltung des AI Act bestraft wird, verliert Vertrauen bei Kunden, Partnern und Aufsichtsbehörden.

Umgekehrt können Unternehmen, die frühzeitig in Compliance investieren, dies als Vertrauensmerkmal kommunizieren. Sie können nachweisen, dass ihre Systeme geprüft, dokumentiert und kontrolliert sind. Sie können sich in Ausschreibungen und Beschaffungsprozessen durch nachweisbare Konformität differenzieren.

Die Rolle von Regulatory Sandboxes

Der AI Act sieht vor, dass jeder Mitgliedstaat bis zum 2. August 2026 mindestens eine regulatorische Sandbox auf nationaler Ebene einrichtet. Diese Sandboxes ermöglichen es Unternehmen, innovative KI-Systeme unter Aufsicht zu testen, bevor sie vollständig auf den Markt gebracht werden.

Regulatory Sandboxes sind besonders relevant für Unternehmen, die neue Anwendungen in Hochrisikobereichen entwickeln. Sie ermöglichen es, regulatorische Anforderungen in einem kontrollierten Umfeld zu testen und anzupassen. Sie schaffen Klarheit darüber, welche Dokumentation und Nachweise erforderlich sind. Sie ermöglichen den Austausch zwischen Entwicklern und Aufsichtsbehörden, bevor ein System offiziell zertifiziert werden muss.

Die spanische AESIA hat ihre Leitfäden auf Basis eines Sandbox-Pilotprojekts entwickelt. Das zeigt, dass Sandboxes nicht nur Testumgebungen sind, sondern auch Lernumgebungen, die zur Entwicklung praktischer Compliance-Standards beitragen.

Strategische Entscheidungen für Produktteams

Produktteams, die KI-Systeme für den europäischen Markt entwickeln, stehen vor strukturellen Entscheidungen. Sie müssen entscheiden, ob sie von Anfang an für Compliance entwickeln oder ob sie nachträglich anpassen. Die nachträgliche Anpassung ist in den meisten Fällen kostspieliger und riskanter. Systeme, die nicht für Logging, Transparenz und menschliche Aufsicht ausgelegt sind, lassen sich nachträglich nur schwer umbauen.

Teams müssen entscheiden, wie sie Dokumentation organisieren. Technische Dokumentation ist nicht etwas, das am Ende eines Projekts erstellt wird. Sie muss parallel zur Entwicklung entstehen. Das erfordert Prozesse, Werkzeuge und Verantwortlichkeiten, die von Anfang an definiert sind.

Teams müssen entscheiden, wie sie mit DSGVO-Anforderungen umgehen. Wenn ein KI-System personenbezogene Daten verarbeitet, muss es eine rechtliche Grundlage haben. Es muss nachweisen, dass es die Rechte betroffener Personen respektiert. Es muss eine Datenschutz-Folgenabschätzung durchlaufen. Diese Anforderungen sind nicht optional.

Teams müssen entscheiden, wie sie mit sektoralen Regelungen umgehen. Ein KI-System im Finanzwesen unterliegt nicht nur dem AI Act und der DSGVO, sondern auch DORA und anderen Finanzregulierungen. Ein System im Gesundheitswesen unterliegt Medizinproduktevorschriften. Diese Überschneidungen müssen in der Entwicklung berücksichtigt werden.

Der Zeitplan: Wann welche Anforderungen gelten

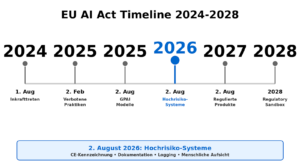

Der EU AI Act wird schrittweise umgesetzt:

1.August 2024: Inkrafttreten

2.Februar 2025: Verbotene Praktiken enden. AI Literacy wird Pflicht.

2.August 2025: Transparenzpflichten für General-Purpose AI Modelle.

2.August 2026: Hochrisiko-Systeme müssen konform sein. Konformitätsbewertung, CE-Kennzeichnung, EU-Registrierung, Qualitätsmanagement, Dokumentation, Logging und menschliche Aufsicht werden Pflicht. Transparenzpflichten für KI-generierte Inhalte werden bindend.

2.August 2027: Hochrisiko-Systeme in regulierten Produkten (Medizinprodukte, Spielzeug, Fahrzeuge).

2028: EU-weite Regulatory Sandbox verfügbar.

Systeme, die 2026 oder 2027 konform sein müssen, sollten bereits heute entsprechend entwickelt werden.

Eine andere Entwicklungslogik

Der EU AI Act erzeugt eine andere Entwicklungslogik für KI-Systeme. Diese Logik ist nicht besser oder schlechter als andere Ansätze. Sie ist anders. Sie priorisiert Nachvollziehbarkeit über Geschwindigkeit. Sie priorisiert Kontrolle über Skalierung. Sie priorisiert dokumentierte Konformität über schnelle Iteration.

Unternehmen, die in Europa tätig sind oder sein wollen, müssen diese Logik verstehen. Sie müssen entscheiden, ob sie ihre Systeme entsprechend anpassen oder ob sie bestimmte Märkte nicht bedienen. Sie müssen Compliance als Produktmerkmal begreifen, nicht als nachträgliche Anpassung.

Die Entwicklung europäischer KI-Systeme im Jahr 2026 ist geprägt von strukturellen Anforderungen, die tief in die Produktarchitektur eingreifen. Diese Anforderungen erzeugen Komplexität. Aber sie erzeugen auch Systeme, die nachweisbar kontrolliert, dokumentiert und auditierbar sind. In Bereichen, in denen Risiken erheblich sind, ist das ein strategischer Vorteil.

Quellen

1. Europäische Kommission – Offizieller Regulierungsrahmen für KI

https://digital-strategy.ec.europa.eu/en/policies/regulatory-framework-ai Offizielle EU-Quelle für den AI Act, Termine und Implementierungsphasen

2. EU Artificial Intelligence Act – Implementierungs-Zeitplan

https://artificialintelligenceact.eu/implementation-timeline/ Detaillierter Zeitplan aller Fristen und Stichtage

3. EU AI Act – Zusammenfassung auf hohem Niveau https://artificialintelligenceact.eu/high-level-summary/ Vollständige Übersicht der Anforderungen für Hochrisiko-Systeme und GPAI

4. CNIL – KI-Systementwicklung & DSGVO-Konformität

https://www.cnil.fr/en/ai-system-development-cnils-recommendations-to-comply-gdpr Offizielle Empfehlungen der französischen Datenschutzbehörde

5. Pearl Cohen – Neue Leitlinien zum EU AI Act (Dezember 2025)

https://www.pearlcohen.com/new-guidance-under-the-eu-ai-act-ahead-of-its-next-enforcement-date/ AESIA 16 Leitfäden, Code of Practice für KI-generierte Inhalte

6. K&L Gates – EU AI Act Update (Januar 2026)

https://www.klgates.com/EU-and-Luxembourg-Update-on-the-European-Harmonised-Rules-on-Artificial-IntelligenceRecent-Developments-1-20-2026 Verordnung (EU) 2024/1689, Bußgelder, DORA, Digital Omnibus

7. PwC – Digital Omnibus Vorschlag (November 2025)

https://www.pwc.com/us/en/services/consulting/cybersecurity-risk-regulatory/library/tech-regulatory-policy-developments/eu-digital-omnibus.html Digital Omnibus zur Vereinfachung der Compliance, Vorschlag vom November 2025